企業でのChatGPTをはじめとした生成AIの活用が進んでいます。一方で、検討の際に「はたしてこの技術は安全なのか」という疑問を持つ方が多いです。「社内の情報が漏洩して、ChatGPTがそれをもとに回答するようになったらどうしよう」という恐怖は、法人での社内利用を考えるにあたり非常に頭の痛い問題です。本記事では、情報セキュリティにおけるリスクマネジメントの観点から、ChatGPTの安全性や注意すべきことについて記載します。

企業におけるリスクマネジメントとは

本記事の論点を考える上で、リスクマネジメントについての最低限の理解が必要です。横文字だらけの説明を読んでも面白くないですので、実例を挙げて考えてみましょう。

皆さんは常日頃から交通事故にあわないように諸々気を付けていることがあると思います。交通事故に遭うかどうかの話は極論でいうと確率の問題なのですが、その確率を下げるためには皆さんは以下のようなことに気を付けて日ごろから行動していると思います。

- 自身が交通ルールを守る

- 危険な運転をしている人間がいたら避ける

- 必要に応じて警察に通報する

- 危険な運転をする車が少ない場所に住む。

ここに列挙したごく当たり前の話よりもさらに確実な方法として、「一切外に出ない」というものがあります。「家に自動車が突っ込んでくる」のような交通事故といっていいのかわからないような可能性は残りますが、交通事故のリスクはほぼゼロにはなります。一方で、外に出ないという選択肢を取った場合、「外に出ることによるメリットがなくなる」という問題は発生します。ここまで極端ではないにせよ「事故が怖いので車には乗らない」というレベルの選択肢を取る人はいると思います。遠くに出るためにはいろいろな制約がかかったり、時間やお金がかかったりはしますが、交通事故に遭遇する確率は確実に下がります。

企業における情報リスクマネジメントも本質的には同様の話です。情報事故に遭う確率をゼロにするのは簡単で「インターネットは一切使わない」更には「経済活動を何もしない」というのがとても有効な手段です。しかしながら、それでは利益を得ることもできません。

ですから、リスクを適切に管理し、会社としての判断を行いながら進めることになります。標準的な運用としては、ISO27001という規格に準拠して管理することが多いです。ごく簡潔に説明すると、この規格では各リスクについて、「リスクが起こる可能性」と「起きた場合の影響」というものの掛け算などで考え、対策方針を判断します。「可能な限りルール化する」「最終的には経営が判断をする」というのも、この規格の重要な考え方です。

この後私が書く情報は「ベンダーから出ている情報」や「一般的な機械学習の知識」をもとにした話になります。そういった情報を100%信用するのも危険ですし、記載されていないデメリットがある場合も当然あります。反面、「信用できない」ということで手を出さないという判断をした場合は利益を受けられない可能性があります。ビジネスへの導入にあたっては、皆様のビジネスにおいてのメリットデメリットを見てご判断いただければと思います。

私たちの生活とセキュリティリスク

ChatGPTは、自然言語、つまり私たちが普段使っている言語を取り扱っているため、セキュリティのリスクが可視化されやすく、関連して起こる問題は必要以上に喧伝されます。パーキンソンの凡俗法則とも呼ばれる現象が起きます。避けるべきリスクは避けなければなりませんが、不必要に恐れるのは良くないことですので、リスクは正しく評価する必要があります。

逆に、気が付かないリスクに対しては私たちはあまり考えずにリスクを許容していることがあります。例えば、スマートスピーカーについて考えてみましょう。スマートスピーカーはちょっとしたお願いを解決してくれたり、好きな音楽をかけてくれたりといった日常の隙間をうめてくれます。一定のキーワードで呼びかけると、スマートスピーカーは反応してくれますが、これは裏を返すと「いつでも発話を待機している」、つまり、物理的にはマイクから音を取り続けることができているということを示唆しています。さらにインターネットに接続している以上、それらの音声は常時どこかに送られている可能性があります。もちろん提供している各社は「不要な音声は送付していない」と主張をしていますが、これをリスクとしてどう評価するかはきちんと考えて判断する必要があります。例えば私は自宅でスマートスピーカーは愛用していますが、仕事部屋にしか置いておらず、リビングなどのプライベート性が強い空間には置いていません。

仕事においても同様のことが言えます。オフィスで労働をしている場合、何かしらのセキュリティリスクが必ず発生します。インターネットを使っていなかったとしても電話やFAXで詐欺を仕掛けられることがあります。インターネットでは、古くから使われている仕組みであってもたとえばメールは標的型攻撃のリスクがあります。

拠点間VPNや強固なFWで防護されているイントラネットも、インターネットへの接続口がある以上は何かしらの攻撃を受けるリスクはありますし、内部のユーザーの不用意な行動によりリスクは爆発的に上がります。例えば、「メールではなくもっと安全なシステムでやり取りを」のように考えたとしても、その新たなシステムで問題が起きる可能性があります。セキュリティについて提供企業が出してきている情報についても、ある程度の基準や根拠をもとにしたものではあるのですが、きちんと自分で評価する必要があります。

前項に書いた通り、きちんと勉強した上で「適切に評価して適切に対応する」という原理原則が非常に重要です。

ChatGPTの導入によるセキュリティリスク

本題のChatGPTのセキュリティリスクについて考えます。

2023年のはじめ、日本国内でもChatGPTが大きく着目されました。この時に「セキュリティはどうなっているのか」という話がされました。タイミング悪く、AmazonやSamsungといった大企業での情報流出のニュースも取りざたされました。

https://pc.watch.impress.co.jp/docs/news/yajiuma/1490904.html

https://www.businessinsider.jp/post-264782

ChatGPTを社内で導入した場合に、基盤側では下記の2パターンの情報漏洩が発生する可能性があります。

- 入力した情報がモデル(ChatGPT)の学習用データとして利用されるリスク

- 入力した情報が何らかの理由で流出するリスク

それぞれのリスクについて考えてみます。なお、「ChatGPT」と呼ばれているものには、OpenAI社が直接提供しているものと、「AOAI」とも呼ばれる、Microsoft社がAzure基盤上で提供しているものがあります。これらはサービスとしてはほぼ同一のものではありますが、提供会社が異なりますのでそれぞれ分けて考えます。また、「ChatGPT」という言葉はWeb上の画面で提供されているインターフェイスを指す場合と、APIで提供されているgpt-3.5-turbo/gpt-4といった大規模言語モデル自体を指す場合があります。こちらについても両方を考えていきます。

本記事ではスコープ外のため取り上げませんが、「ChatGPTへ接続しているアプリケーション側を起因とする情報漏洩」というパターンもあり得ます。こちらについても頭の痛い問題ではあるのは承知しておりますが、アプリケーションによってリスクも発生確率も異なりますので、本記事では説明を割愛します。

入力した情報が学習用データとして利用されるリスク

ChatGPTはインターネット上の莫大なテキストデータをモデルの生成・改善に使っています。これにはChatGPT自体にユーザーが入力した情報も含まれます。業務用のデータを入力した場合、それがモデルに反映される可能性があり情報漏洩のリスクがあるといわれています。このリスクについて、実際のところどうなのかを調べてみましょう。各社が出している情報をベースに考えます。

まず、OpenAI社についてです。OpenAI社が出している情報を引用します。

https://help.openai.com/en/articles/5722486-how-your-data-is-used-to-improve-model-performance

ChatGPT

When you use our non-API consumer services ChatGPT or DALL-E, we may use the data you provide us to improve our models. You can switch off training in ChatGPT settings (under Data Controls) to turn off training for any conversations created while training is disabled or you can submit this form. Once you opt out, new conversations will not be used to train our models.

API

OpenAI does not use data submitted to and generated by our API to train OpenAI models or improve OpenAI’s service offering. In order to support the continuous improvement of our models, you can fill out this form to opt-in to share your data with us.

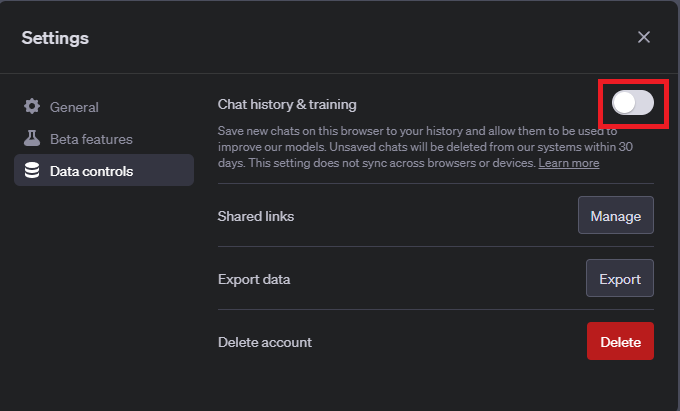

簡単に翻訳すると、ChatGPTのWebUI、つまり一般的に「ChatGPT」と呼ばれているサービスに入力した情報は学習される可能性があるということです。ただし、OpenAIの情報にも書いてある通り、入力した情報が学習されないように設定変更をすることができます。ChatGPTのUIの左下のユーザー名が表示されているところをクリックし、Setting & Betaをクリックしてください。出てきたメニューから、Data controlsを選択し、Chat history & trainingのスイッチをオフにするとオプトアウトが可能です。

この設定をすると履歴が表示されなくなり、また新規に入力したものについてもChatGPTの学習には使われなくなります。しかしながら、今まで入力したものについては学習につかわれてしまいます。これは機械学習の「使ったデータの影響を除去するのが難しい」という性質によるものと考えられます。

一方で、APIについては、学習に使わないことが明示されています。つまりシステムからAPI経由でアクセスした場合、情報は学習に利用されないという建付けになっています。これはいわゆる微調整とも呼ばれるfine tuning(こちらのデータをもとにモデルの改善を行う)をOpenAI環境上で行った場合も話は同じです。

続いて、MS社のAOAI環境についても引用します。

重要

Your prompts (inputs) and completions (outputs), your embeddings, and your training data:

- are NOT available to other customers.

- are NOT available to OpenAI.

- are NOT used to improve OpenAI models.

- are NOT used to improve any Microsoft or 3rd party products or services.

- are NOT used for automatically improving Azure OpenAI models for your use in your resource (The models are stateless, unless you explicitly fine-tune models with your training data).

- Your fine-tuned Azure OpenAI models are available exclusively for your use.

The Azure OpenAI Service is fully controlled by Microsoft; Microsoft hosts the OpenAI models in Microsoft’s Azure environment and the Service does NOT interact with any services operated by OpenAI (e.g. ChatGPT, or the OpenAI API).

記載されている通り、Azureの環境においては入力されたデータがModelの改善に使われることはありません。fine tuningしたデータが他に使われることもありません。

入力した情報が何らかの理由で流出するリスク

「入力した情報を使わない」と両社が主張しているのはわかりました。その主張が正しいとしても、「入力したデータがどこからか流出する」というリスクは残ります。各社がそれぞれ出している情報を確認します。まずはOpenAI社からです。

https://openai.com/security

https://trust.openai.com/

OpenAI社のセキュリティについては上のページに記載があります。後者のURLはOpenAIセキュリティポータルで、登録するとリアルタイム性の高い情報が提供されます。OpenAI社はSOC2 Type2という、半年以上の長期スパンで情報マネジメントが適切に取り扱われているかどうかの検証が行われています。この報告を信じるのであれば、ある程度信用はしていいと考えます。

https://www.sbbit.jp/article/cont1/105732

また、ニュースによると、OpenAI社の環境はAzure上に構築されています。よって、クラウド基盤自体への信頼性はAzureに準じると考えて良いでしょう。

https://learn.microsoft.com/ja-jp/azure/compliance/

Azureについては、こちらに認証がまとめられております。

ISO27001/27017をはじめとした認証を取得しています。

https://www.ismap.go.jp/csm?id=cloud_service_list

また、デジタル庁が制定している「政府情報システムのためのセキュリティ評価制度」にもAzureは認定されており、ある程度安全だと考えて良いでしょう。

まとめ

当記事の執筆日現在の情報を見る限り、以下のような評価となります。

- OpenAI社が提供しているChatGPTのWeb画面からアクセスする場合設定変更することでリスクが低減される

- Azure/OpenAIともにAPI利用による情報漏洩の危険性は小さい

どういう選択をとってもリスクはゼロにはなりませんが、業務にもたらすプラスの影響と相談しながらうまく付き合っていきたいと考えております。コンタクトセンターでの顧客対応等で導入を検討なさっている場合は、ぜひ弊社にご相談ください。

執筆者紹介

- TOPIC:

- プロフェッショナル

- 関連キーワード:

- 生成AI

- トレンド

- DX(デジタルトランスフォーメーション)

- プロフェッショナルブログ